Makrosites

Suas ideias em realidade digital!

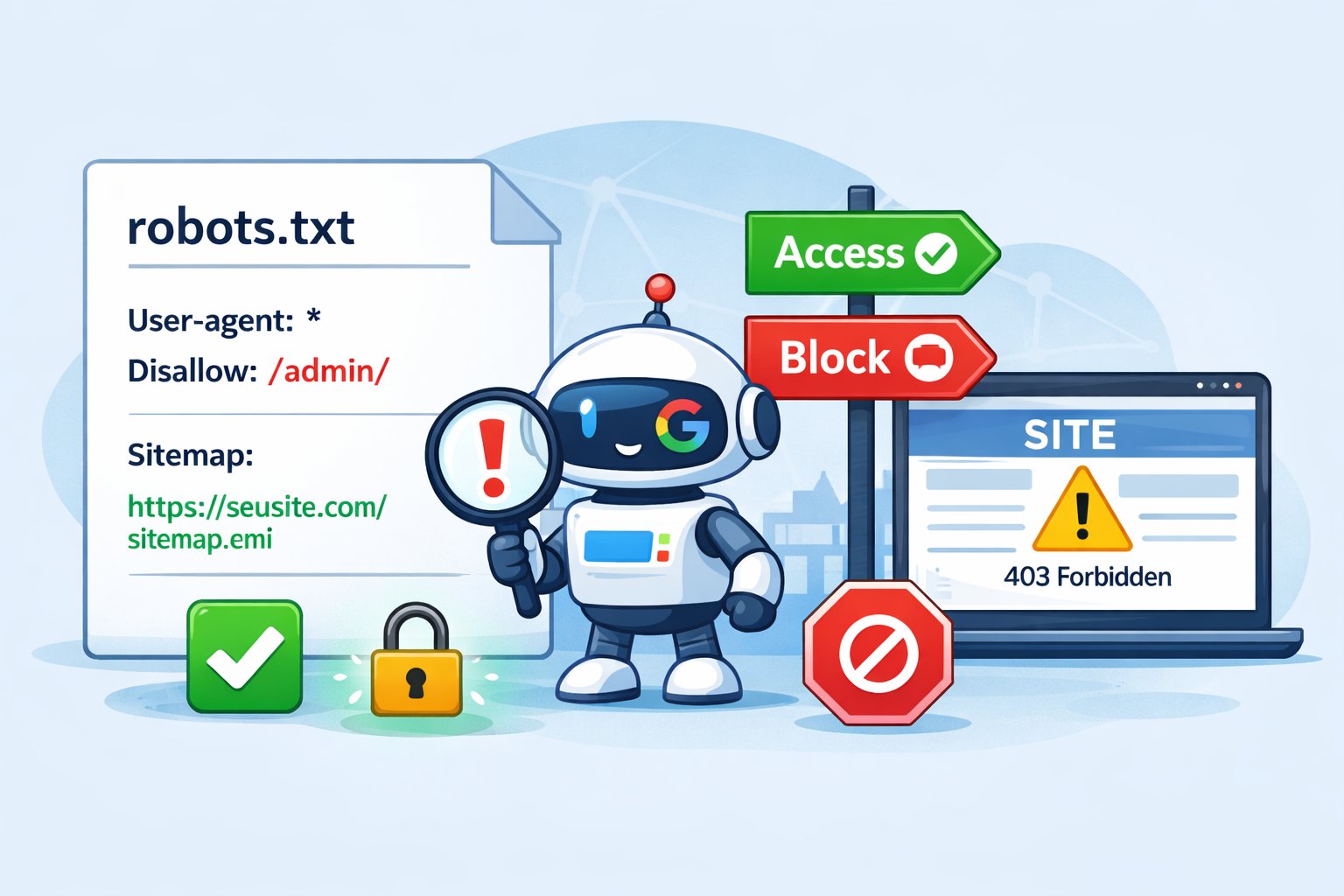

O que é o arquivo robots.txt?

O robots.txt é um arquivo de texto usado para controlar o acesso de robôs de busca, como o Googlebot, às páginas do seu site.

Para que serve o robots.txt?

- Bloquear pastas que não devem ser indexadas

- Evitar indexação de páginas administrativas

- Indicar o caminho do sitemap

- Controlar o rastreamento do site

Exemplo básico de robots.txt

User-agent: * Disallow:

Esse exemplo permite que todos os robôs acessem o site inteiro.

Bloquear pastas específicas

User-agent: * Disallow: /admin/ Disallow: /login/

Erro comum: bloquear o site inteiro

Um dos erros mais comuns é:

User-agent: * Disallow: /

Esse comando impede que o Google indexe qualquer página do site.

Adicionar sitemap no robots.txt

É altamente recomendado informar o sitemap:

Sitemap: https://www.seusite.com/sitemap.xml

👉 Gere um sitemap válido usando nosso Gerador de Sitemap XML .

Robots.txt x meta robots

O robots.txt controla o rastreamento,

enquanto a meta tag:

<meta name="robots" content="noindex">

controla a indexação da página.

Como testar o robots.txt

Use a ferramenta do Google Search Console para testar regras e verificar se uma URL está bloqueada.

Erros comuns relacionados ao robots.txt

- Bloquear CSS e JS importantes

- Esquecer de liberar páginas públicas

- Apontar sitemap inexistente

Verificar URLs bloqueadas

Se o site não está indexando corretamente, verifique se URLs importantes não estão bloqueadas.

👉 Use o Verificador de URLs para validar suas páginas.

Conclusão

O robots.txt é um arquivo simples, mas extremamente poderoso. Uma configuração errada pode impedir totalmente a indexação do site.

Manter o robots.txt correto, junto com sitemap válido e URLs funcionais, é essencial para SEO técnico.